Size Matters/fr

│

Deutsch (de) │

English (en) │

français (fr) │

русский (ru) │

中文(中国大陆) (zh_CN) │

Introduction

Cette page porte sur les tailles de binaires. Au fil des années il y a eu beaucoup de confusion sur les tailles binaires FPC et Lazarus. Avant de faire des remarques dans les listes de diffusion, SVP, lisez cette FAQ.

La principale raison pour cette FAQ est que la plupart des discussions sur ce sujet ont tendance à tomber trop rapidement dans les détails. Aussi, l'opinion de gens qui crient "envahit" presque tout et obscurcit l'image globale souvent plus qu'il ne contribue à la clarté.

Règle générale, que sont les tailles réalistes actuels pour les binaires FPC/Lazarus ?

- Tout ce qui est en dessous de 1 Mo n'est pas un problème.

- Assurez-vous qu'ils sont correctement dépouillés (stripped) et liés intelligemment avant la mesure et que TOUTES les bibliothèques sont construites en utilisant la liaison intelligente.

- NE PAS FAIRE DE binaires UPX par habitude, a moins d'avoir de très bonnes raisons de le faire (voir en dessous). La taille est moins importante que la charge mémoire qu'un binaire décompressé provoque. La mémoire est plus chère que l'espace disque. La plupart des outils d'accès à distance implémente la compression dans leur tunnel.

- Avec de petites apps, c'est plus dur à estimer. C'est parce que la taille exacte de la RTL dépend de l'OS. Toutefois, 100ko de binaire autonome qui fait quelque chose peut être fait en général en dessous de 50ko.

- Sous windows 20k d'IHM utilisant des binaires ne sont pas un problème.

- L'unité SysUtils contient l'internationalisation, des messages d'erreur en texte, la gestion des exceptions et d'autres trucs qui sont toujours liés quand cette unité est employée (penser à un total de 40-100k).

- Les apps Lazarus sur Windows font environ 500ko, mais grossissent rapidement à 1,5 Mo et de plus en plus avec les widgets Lazarus utilisés. Les apps binaires Lazarus peuvent passer à plus de 100 Mo quand les infos de débogage sont liées dedans (comparable aux infos TD32 dans Delphi).

- C'est un peu plus que lorsqu'on recompile avec une ancienne version de Delphi, et un peu moins qu'avec les versions modernes de Delphi (D2009+ la taille minimale de la RTL bondit fortement), c'est le prix de pour la compatibilité croisée de plate-forme et la maintenabilité des projets.

- Quand le moment est atteint l'ajout de code supplémentaire n'introduit pas de nouvelles dépendances, cette croissance rapide disparaît.

- Le point des 1,5Mo du dessus est une règle d'or. Il dépend beaucoup du style de création de votre IHM et du nombre de différents Widgets que vous utilisez et de leur complexité.

- Pour les applications Lazarus, une partie du binaire n'est pas du code, la plupart sont des chaînes et des tables.

- Les simples binaires Linux/FreeBSD sont plus gros que les GCC correspondants. C'est parce qu'ils n'utilisent pas de bibliothèques partagées (ce que vous pouvez facilement voir

ldd ./xx) - Les binaires 64 bits sont toujours plus gros que leurs équivalents x86. En général, les plates-formes RISC génèrent aussi des binaires légèrement plus gros.

Pourquoi les binaires sont si gros ?

Réponse: Ils ne sont pas censés être grand.

Si vous les percevez comme gros, alors

- soit vous n'avez pas configuré FPC proprement, ou

- vous avez une attente irréaliste de la taille que devrait avoir le binaire

- vous essayer de faire quelque chose pour laquelle FPC n'est pas conçu.

Le dernier est sans le moins probable des trois. Je vais traiter ces trois cas rapidement dans les prochains paragraphes.

Est-ce mauvais quand les binaires sont gros ?

Bien, cela dépend de l'ampleur du parcours. Mais il est sûr de dire que presque personne ne devrait être inquiet d'avoir des binaires gros de quelques Mo ou même plus de 10 Mo pour des applications considérables.

Cependant, il y a encore quelques catégories qui pourraient vouloir avoir un certain contrôle sur les fichiers binaires en les gardant petits.

- Le monde de la programmation embarquée évidemment (et alors je ne veux pas dire les PC embarqués qui ont toujours des dizaines de Mo).

- les gens qui distribuent vraiment quotidiennement par modem

- Concours, mesures de performance

Notez qu'une idée fausse souvent citée est celle que des binaires plus gros sont plus lents en fonctionnement. En général, cela n'est pas vrai, 'exotic last-cycle stuff as code cachelines'(non traduit) mis à part.

Embarqué

Alors que Free Pascal est raisonnablement utilisable pour des usages embarqués ou de système, les décisions d'ingénierie de la version finale et de compromis sont basées sur les exigences de construction d'applications plus générales, bien que certaines des cibles les plus intégrées (comme DOS 16 bits ou ARM/AVR/MIPS (= PIC32) étendent cela à la limite.

Si vous avez des besoins aussi spécialisés pour des objectifs plus réguliers, vous pouvez définir un projet dans l'ombre (quelque chose comme les versions spécialisées de certaines distros Linux qui sont disponibles). Ennuyer l'équipe FPC qui est déjà surchargée avec ces besoins spécifiques n'est pas une option, d'autant plus que la moitié des utilisateurs embarqués sérieux roulent de toutes façons.

distribution par modem

Le cas du modem n'est pas seu1ement "télécharger depuis Internet" ou "mon shareware doit être aussi petit que possible", mais p.ex. dans mon ancien travail nous faisions un tas de déploiement vers nos clients et vers nos sites externes via le bureau distant sur le RNIS. Mais même avec un modem 56k, vous ne pouvez pas envoyer 1 Mo en moins de 5 minutes.

Veillez à ne pas abuser de cet argument pour essayer de fournir un fondement rationnel mal placé pour une opinion émotionnelle sur la taille binaire. Si vous faites ce point, cela ne sert à rien sans une analyse statistique approfondie du pourcentage d'utilisateurs de modem réels que vous avez pour votre application (ma plupart des utilisateurs de logiciels ne téléchargent pas depuis Internet mais depuis les CD des magazines de shareware (NdT: ce point de vue n'est plus valbale actuellement).

Concours

Une autre raison pour garder les binaires petits sont les comparaison de langages (comme le Language Shootout). Cependant ceci est plus comme résoudre un puzzle, et pas vraiment lié au génie logiciel responsable.

Configuration de compilateur incorrecte

Je ne suis pas en train d'expliquer chaque aspect de la configuration du compilateur de manière détaillée, puisque c'est une FAQ, non un manuel. C'est juste un survol. Lire manuals et buildfaq de manière approfondie pour une information plus fondamentale.

Il y a généralement plusieurs raisons de pourquoi un binaire semble plus gros qu'attendu. Cette FAQ couvre les raisons les plus courantes, en ordre décroissant de probabilité:

- le binaire contient encore des informations de débogage.

- le programme n'a pas été (complétement) lié intelligemment.

- Le binaire inclut des unités contenant des sexctions d'initialisation qui execute beaucoup de code.

- vous liez statiquement des biblitohèques externes, plus qu'utilisez des liaisons dynamiques (bibliothèques partagées).

- L'optimisation n'est pas (complètement) activée.

- Le fichier de projet Lazarus (lpr) a des unités de paquet dans sa section uses (c'est fait automatiquement par Lazarus)

Dans le futur, les liaisons partagées vers une bibliothèque d'exécution FPC et/ou Lazarus devrait changer cette image de manière significative. Bien sûr, cela vous aurez à distribuer une grosse DLL withe pleins d'autres trucs dedans qui vous amènera à des problèmes de versioning).

Tout cela est encore dans le futur, il est donc difficile de quantifier l'impact sur les tailles binaires. Surtout parce que la liaison dynamique a également une surcharge de taille (en plus du code inutilisé dans la bibliothèque partagée).

Information de débogage

Free Pascal utilise GDB comme débogueur et LD comme éditeur de liens. Ceux-ci travaillent avec des infos de débogage dans le binaire, dans l'ancien format stabs ou le plus récent dwarf. Les gens voient souvent p.ex. des binaires qui font 40 Mo. La bonne taille devrait être autour de 6Mo, le reste sont des informations de débogage (et peut-être 6 Mo pour de la liaison intelligente mal faite).

L'info de débogage Stabs est plutôt encombrante, mais a l'avantage d'être relativement indépendante du format binaire. Elle a été remplacée par DWARF sauf pour certaines plates-formes légataires.

Il y a souvent confusion en ce qui concerne les informations de débogage, qui est causée par le strip dans de nombreuses versions win32 des binutils. Aussi certaines versions du binaire Win32 de strip n'élimine pas totalement les infos de débogage générées par FPC. Donc les gens bascule le drapeau tel que -Xs (ligne de commande Lazarus/IDE ou FPC) et suppose que cela marche alors que non. FPC a été adapté pour remédier à cela.

Donc dans le doute, tenter toujours de faire le strip manuellement, et sur Windows, avec plusieurs binaires STRIP différents.

Ce genre de problème devient plus rare particulièrement sur Windows, depuis que l'éditeur de liens interne traite ces problèmes de façon plus consistante. Néanmoins (nez en moins ;-), il s'applique toujours pour les personnes qui utilisent des cibles exotiques pendant un certain temps encore.

Vous pouvez utiliser le système de Strip pour livrer la même construction entre la version allégée (strippée) pour l'utilisateur et conserver la version complète (non strippée) pour p.ex. l'interprétation des adresses de trace arrière. Ainsi, si vous faites des livraisons formelles, conservez toujours une copie complète du binaire que vous enverrez qui sera allégé.

La conception de GDB lui-même vous laisse garder et utiliser les informations de débogage en dehors du fichier binaire (infos de débogage externes), dans un fichier séparé .gdb. La taille du binaire résultant n'est pas augmentée du fait des infos de débogage, et vous pouvez toujours réussir à déboguer le binaire. Vous n'avez pas besoin du fichier .dbg pour exécuter l'application, il est utilisé uniquement par le débogueur. Comme les infos de débogage sont externes, il est utile d'utiliser strip.

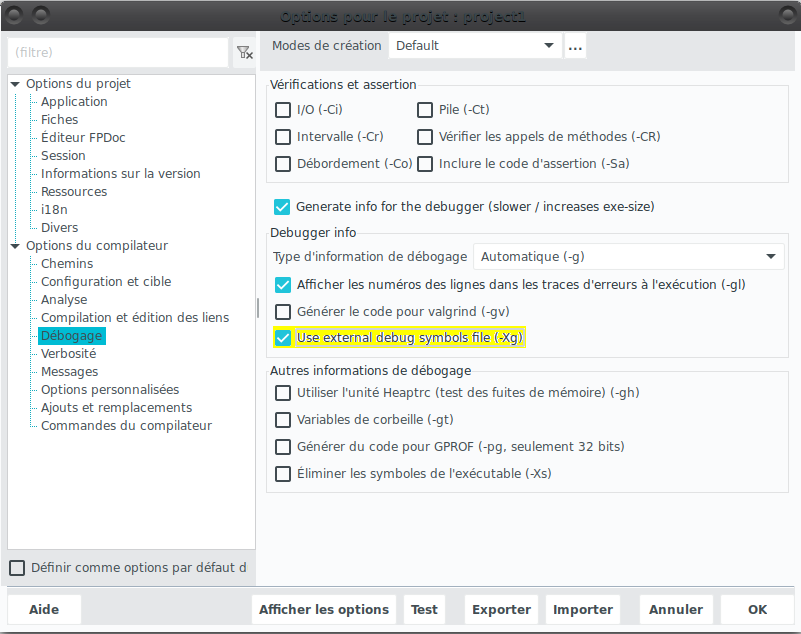

Pour compiler votre application de cette façon, vous devriez utiliser la bascule -Xg ou l'option correspondante dans l'IHM de Lazarus : dans 'Projet|Options du projet|Options du compilateur|Débogage', laissez 'Generate info for the debugger' active et activez 'Use external debug symbols file'.

Une application avec une fenêtre vide pour Win32, compilée avec des infos de débogage externes doit occuper environ 1 Mo, et le fichier .dbg environ 10 Mo.

Liaison intelligente

(main article principal: File size and smartlinking)

La principe fondamental de la liaison intelligente est simple et bien connu : ne pas lier ce qui ne sert pas. Ceci a bien sûr un bon effet sur la taille du binaire.

Pourtant, le compilateur est seulement un programme et n'a pas une boule de cristal magique pour voir ce qui est utilisé, aussi l'implémentation de base est plutôt comme cela :

- Le compilateur divise le code en soi-disant "sections" qui sont assez petites.

- Ensuite le compilateur détermine quelles sections sont utilisées ne employant la règle "si aucune étiquette dans cette section n'est utilisée alors elle peut être éliminée".

Il y a quelques problèmes avec cette vision simpliste:

- les méthodes virtuelles peuvent être implicitement appelées via leur VMTs. L'éditeur de liens GNU ne peut pas tracer des séquences à travers ces VMTs, donc elles sont toutes liées dans le binaire;

- Les tables pour les chaînes de ressource font référence à chaque constante de chaîne, et donc toutes les constantes de chaîne sont liées (une des raisons pour lesquelles sysutils est gros).

- Des symboles qui peuvent appelés depuis l'extérieur du binaire (c'est aussi possible pour les binaires ELF qui ne sont pas des bibliothèques) doivent être conservés. Cette dernière limitation est nécessaire pour éviter stripping des fonctions exportées depuis les bibliothèques partagées.

- Les fonctions et propriétés publiées, qui doivent être conservées, constituent un autre problème de ce type. Les références aux fonctions/propriétés publiées peuvent être construites à la volée en utilisant des opérations de chaîne, et le compilateur ne peut tracer cela. C'est l'un des inconvénients de la réflexion.

- Les propriétés publiées et les méthodes doivent être résolues en créant les noms de symboles en utilisant de la manipulation de chaîne, et doivent donc être liées si la classe est référencée n'importe où. Le code publié pourrait à son tour appeler un code privé/protégé/public et donc une inclusion assez importante.

Un autre effet de bord important qui est logique (mais souvent oublié) est que cet algorithme liera tout ce qui est référencé dans les section initialization et finalization des unités, même si aucune fonctionnalité de ces unités n'est utilisée. Donc soyez prudent avec ce que vous utilisez.

Quoi qu'il en soit, la plupart des problèmes liés à l'utilisation de la liaison intelligente proviennent du fait que pour le plus petit résultat, FPC nécessite généralement que "compile with smartlinking" soit activé LORS DE LA COMPILATION DE CHAQUE ET DE CHAQUE UNITÉ, MÊME LA RTL.

La raison pour cela est simple. LD ne pouvait faire des liaisons «intelligentes» que des unités de la taille d’un fichier .o entier jusqu’à assez récemment. Cela signifie que pour chaque symbole un fichier .o séparé doit être fabriqué (et ensuite ces dizaines de milliers de fichiers .o sont archivés dans un des fichiers .a). C'est une tâche consommatrice de temps (et de mémoire du lieur), donc c'est optionnel et activé seulement pour les versions de livraison, pas pour les instantanés (snapshots). Souvent les gens qui ont des problèmes avec la liaison intelligente utilise un instantané qui contient des RTL/FCL etc qui n'ont pas été liées intelligemment. La seule solution consiste à recomplier le source avec la liaison intelligente activée (-CX). Voir buildfaq plus d'infos.

A l'avenir, ceci sera amélioré quand le compilateur émettra du code lié intelligemment par défaut, au moins pour les cibles principales. Ceci sera rendu possible par deux développements séparés. D'abord, LD l'éditeur de liens GNU peut maintenant lier intelligemment de manière plus fine (au moins sous Unix) en utilisant --gc-sections; ensuite l'arrivée de l'éditeur de liens interne à FPC (dans la brance 2.1.1) pourt toutes les plates-formes fonctionnant (wince/win32/win64). L'édition de liens intelligente utilisant LD --gc-sections a encore beaucoup de problèmes car la disposition exacte de l'assembleur et de nombreux détails concernant les tableaux doivent être recherchés, nous entrons souvent dans des problèmes typiques avec les développement GNU ici, les outils sont à peine testés (ou parfois même pas implémentés, voir le standard DWARF) en dehors de ce que GCC utilise/souligne. De plus, les versions des cibles non * nix sont souvent basées sur des versions plus anciennes (pensezà DOS, go32v2, amiga ici).

L'éditeur de liens interne peut maintenant lier intelligemment Lazarus (17 secondes pour une liaison intelligente complète sur un Athlon64 3700+ utilisant environ 250 Mo de mémoire) ce qui est plutôt bon, mais seulement pour Windows et 2.1.1 pour le moment. L'éditeur de liens interne ouvre aussi la porte à des liaisons intelligentes plus avancées qui demande des connaissances spếcifiques à Pascal, comme abandonner une méthode virtuelle (20 % sur la taille du code des exemples Lazarus, 5 % sur l'EDI Lazarus en première estimation grossière), et traitant mieux les cjaîbne des ressource inutilisées. Tout ceci est en alpha, et les statistiques du dessus sont probablement trop optimistes, puisque Lazarus ne travaille pas encore avec ces optimisations.

Pendant une discussion sur Stack Overflow, certains détails extra viennent en avant (et la plupart les mêmes pour FPC comme pour Delphi, au moins sous Windows) :

Sections initialization et finalization

Si vous incluez une unité en section USES, même quand il s'agit de USES indirects à travers une unité différente, alors SI l'unité contient des sections initialization ou finalization, ce code et ses dépendances sont toujours liés.

Une unité pour laquelle c'est important est sysutils. Conformément à la compatibilité Delphi, sysutils convertit les erreurs d'exécution en exceptions avec un message textuel. Toutes les chaînes de sysutils réunies sont un peu volumineuses, il n'y a rien qui puisse être fait contre cela, à part de retirer un paquet d'initialisations de sysutils qui la rendra incompatible avc Delphi. C'est donc plus une chose pour une version embarquée, si une telle équipe se portait volontaire.

Binaires statiques

(main article: Lazarus/FPC Libraries)

On peut aussi faire des binaires totalement statiques sur chaque système d'exploitation, en incorporant toutes les bibliothèques dans le binaire. Cela est fait en général pour faciliter le déploiement, mais cela produit par là-même d'énormes binaires. Puisqu'il s'agit du "territoire des sorciers" (wizard territory), je ne le mentionne que par souci d'exhaustivité. Les personnes qui font cela le font en connaissance de cause, nous l'espèrons.

Au lieu de produire des binaires statiques, des programmeurs font de la liaison dynamique / partagée. Cela PEUT générer un binaire exécutable beaucoup, beaucoup plus petit. Pourtant, il existe des cas où le binaire devient plus gros, en particulier sur des architectures comme x86_64 où le PIC est activé par défaut. La liaison dynamique (Win32) et la liaison partagée (*nix) sont le même concept, mais leur fonctionnement en interne est différent, comm cela peut être vu par le fait que les systèmes *nix ont besoin des bibliothèques partagées sur l'hôte pour faire le lien (croisé), alors que pour lier un binaire Windows vous n'avez pas besoin des DLLs nécessaires sur le système.

Optimisation

L'optimisation peut également réduire un peu la taille du code. Le code optimisé est généralement plus serré (mais seulement en dixième de pourcent). Assurez-vous d'utliser l'option -O3. Voir aussi Optimisation globale de programme pour davantage de réduction de la taille du code.

Fichier lpr de Lazarus

Dans Lazarus, si vous ajoutez un paquet à votre projet/fiche, vous obtenez que l'enregistrement de son unité est ajouté au fichier lpr. Le fichier lpr n'est normalement pas ouvert. Si vous voulez l'éditer, vous l'ouvrez d'abord (via Projet|Voir le code source du projet). Ensuite vous retirez toutes les unités non nécessaires telles que les interfaces, les fiches, les seules fiches requises sont vos propres unités de fiches, toutes les autres choses ne sont pas nécessaires mais vous devez vous assurez de ne pas supprimer d'unité qui enregistre des choses telles que des lecteurs d'images (jpeg) ou des cas de test. (Ndt: C'est cependant un exercice risqué car cela supposerait de connaître l'évolution future des unités utilisées)

Vous économisez alors des mégaoctets ET quelques dépendance en liaison aussi si vous utilisez des gros paquets (tels que glscene).

Ce type de comportement est typique pour les bibliothèques qui font beaucoup de section d'initialisation d'unités. Remarquez que peu importe où elles sont utilisées (lpr ou unité normale). Bien sûr, la liaison intelligente essaie de minimiser ces effets.

Problèmes 2.2.0

(non traduit car sans doute obsolète bien que non vérifié) There appear to be some size problems in FPC 2.2.0 is this still relevant for 2.6.x/2.7.x? Note that these remarks hold for the default setup with internal linker enabled.

- It seems that FPC 2.2.0 doesn't strip if any -g option is used to compile the main program. This contrary to earlier versions where -Xs had priority over -g

- It seems that FPC 2.2.0 doesn't always smartlink when crosscompiling. This can be problematic when compiling for windows, not only because of size, but also because dependencies are created to functions that might not exist.

UPX

(non traduit, version 2.6 trop ancienne) Note: UPX support in makefiles, and the distribution of upx by FPC ceased after 2.6.0. New releases of FPC won't package upx any more

The whole strange UPX cult originates mostly from a mindless pursuit of minimal binary sizes. In reality UPX is a tool with advantages and disadvantages.

The advantages are:

- The decompression is easy for the user because it is self-contained

- Some size savings are made if (and only if) the size criterion is based on the binary size itself (as happens in demo contests). However, especially in the lowest classes it might be worthwhile to minimize the RTL manually and to code your compression yourself, because you can probably get the decompression code much tighter for binaries that don't stress all aspects of the binary format.

- For rarely used applications or applications run from removable media the disk space saving may outweigh the performance/memory penalties.

The disadvantages are:

- worse compression (and also the decompression engine must be factored into _EACH_ binary) by archivers (like ZIP) and setup creation tools

- decompression occurs on every execution, which introduces a startup delay.

- Since Windows XP and later now feature a built-in decompressor for ZIP, the whole point of SFX goes away a bit.

- UPXed binaries are increasingly being fingered by the malware heuristics of popular antivirus and mail-filtering apps.

- An internally compressed binary can't be memorymapped by the OS, and must be loaded in its entirety. This means that the entire binary size is loaded into VM space (memory+swap), including resources.

- You introduce another component (UPX, decompression stub) that can cause incompatibilities and problems.

The memorymapping point needs some explanation: With normal binaries under Windows, all unused code remains in the .EXE, which is why Windows binaries are locked while running. Code is paged in 4k (8k on 64-bit) at a time as needed, and under low memory conditions is simply discarded (because it can be reloaded from the binary at any time). This also applies to graphic and string resources.

A compressed binary must usually be decompressed in its entirety, to avoid badly affecting the compression ratio. So Windows has to decompress the whole binary on startup, and page the unused pages to the system swap, where they rot unused, and also take up extra swap space.

Coûts de cadre d'application (Framework)

Un cadre d'application (ou cadriciel) réduit grandement la quantité de travail pour développer une application.

Cela a cependant un coût, car un framework n'est pas une simple bibliothèque, mais plutôt un sous-système entier qui traite de l'interfaçage avec le monde extérieur. Un framework est conçu pour un ensemble d'applications qui peuvent accéder à de nombreuses fonctionnalités (même si une seule application ne le peut pas).

Cependant, plus un framework peut accéder à des fonctionnalités, plus un certain sous-ensemble minimal devient grand. Pensze à l'internationalisation, au support des ressources, aux environnements de traduction (traduction sans recompilation), messages d'erreur siginificatifs pour les exceptions de base. Tout ceci est appelé les frais généraux du cadre d'application (framework overhead).

La taille d'une application vide n'est pas due aux inefficiences du compilateur mais aux frais généraux du cadre d'application. Le compilateur ôtera le code inutilisé automatiquement, mais tout le code ne peut pas l'être. La conception du cadre d'application détermine quel code le compilateur est capable d'enlever lors de la compilation.

Certains cadre d'application sont à l'origine de très petits frais généraux, alors que d'autres en amènent de plus gros. Tailles attendues pour les applications vides sur des cadriciels bien connus:

- Aucun cadriciel (seulement la RTL): +/- 25kb

- Aucun cadriciel (RTL+sysutils seulement): +/- 100-125kb

- MSEGUI: +/- 600kb

- Lazarus LCL: +/- 1000kb

- Free Vision: +/- 100kb

- Key Objects Library: +/- 50kb

En bref, choisissez bien votre cadriciel. Un cadriciel puissant peut vous faire économiser beaucoup de temps, mais si l'espace est compté (cas du code embarqué), un cadriciel plus petit pourrait être un meilleur choix. Mais assurez d'avoir besoin de ce gain de place. De nombreux amateurs choisissent par habitude le plus petit cadriciel et finissent avec du code immaintenable puis arrêtent. Ce n'est pas drôle de maintenir des applications dans de multiples cadriciels pour gagner quelques ko.

Remarquez par exemple que le cadriciel de Lazarus est relativement lourd du fait de l'utilisation de la RTTI et de l'introspection pour ses mécanismes de flux, et pas seulement la taille du source. la RTTI rend plus de code accessible en dégradant les performances de la liaison intelligente.

Attentes irréalistes

Beaucoup de gens regardent la taille d'un binaire et s'écrient Gonflé!. Quand vous tentez d'argumenter avec eux, ils se cachent derrière des comparaisons (mais TP produit ...), ils ne disent jamais réellement 'pourquoi' ils sont besoin d'un binaire qui soit plus faibles sur tous les coûts. Certains d'entre eux ne réalisent même pas qu'un code 32-bit (maintenant 64-bit) est TOUJOURS plus gros qu'un code 16-bit (maintenant 32-bit) ou que l'indépendance à un SE a un coût ou ..., ou ..., ou ...

Comme dit plus haut, avec la taille actuelle des disques durs, il n'y a pas de raison de garder les binaires avec des tailles très petites. les binaires FPC étant 10, 50 ou même 100% plus grands que ceux des compilateurs du précédent millénaire ne devraient pas avoir beaucoup d'importance. Un bon indicateur de ces visions est le sur-emploi franchement émotionnel et infondé d'UPX (voir au dessus), qui est un signe de la folie de la taille du binaire, puisque cela n'a pas de sens techniquement parlant.

Alors d'où vient cette émotion ? S'agit-il simplement de résister au changement ou d'être des maniaques de contrôle ? Je n'ai jamais vu beaucoup de cause justifiée, sauf que parfois certains d'entre eux poussaient leurs propres bibliothèques inférieures et essayaient de gagner du terrain contre des bibliothèques bien établies basées sur des arguments de taille. Mais cela n'explique pas tous les cas, donc je pense que la taille binaire est vraiment le dernier artefact "640k devrait être suffisant pour n'importe qui" (Ndt: citation de Bill Gates). Même si ce n'est pas réel, mais juste mental.

Une fausse révélation pour cela est que le nombre de correctifs réalistes dans ce domaine est proche de zéro, sinon zéro. Ce sont uniquement des discussions maillist, et des mods RTL triviaux qui ne gagnent presque rien et qui entravent sérieusement la création de vraies applications et la compatibilité (et je ne suis pas un maniaque de la compatibilité pour commencer). Personne ne s'assoit pendant quelques jours et fait une enquête approfondie et propose des correctifs. Il n'y a pas de RTL réduite entretenue en externe, pas de jeux de correctifs, etc., alors que ce serait extrêmement facile. D'une manière ou d'une autre, les gens ne sont après le dernier octet que si c'est facile à réaliser, ou s'ils ont quelque chose de "moins gonflé" à promouvoir.

Quoi qu'il en soit, les quelques personnes embarquées que je connais qui utilisent FPC de manière intensive ont toutes leurs propres bibliothèques personnalisées. Pour une personne, l'internationalisation compte même lorsqu'elle est intégrée (car elle parle une langue avec des accents), et les exceptions ne comptent pas, pour quelqu'un d'autre, les exigences sont encore différentes. Chacun a ses propres compromis et choix, et si l'espace est «vraiment» restreint, vous ne faites pas de compromis pour utiliser la distribution générale.

Et oui, FPC pourrait utiliser quelques améliorations ici et là. Mais ceux-ci ne devraient pas nuire à la «programmation générale», à la nature multiplateforme du FPC, à la facilité d'utilisation et à être réaliste dans les besoins en main-d'œuvre. Les choses complexes prennent du temps. Les optimiseurs globaux ne tombent pas du ciel facilement

Comparaisons avec GCC

Les comparaisons avec GCC sont un peu moins irréalistes. Même les développeurs se reflètent (et FPC) régulièrement dans GCC. Bien sûr, GCC est un monstre sponsorisé par une entreprise, qui est également le favori mondial de l'Open Source. Toutes les comparaisons ne sont pas raisonnables ou équitables. Même les compilateurs qui se basent sur GCC ne supportent pas toutes les fonctionnalités "c" de gcc fortement sponsorisées.

Néanmoins, compte tenu des différences de taille des projets, FPC fait un travail étonnamment bon. La vitesse est correcte, sauf peut-être pour certains cas de calcul fortement scientifique, les tailles binaires et l'utilisation de la mémoire sont suffisantes voire meilleures en général, le nombre de plates-formes ne déçoit pas (même s'il est dommage qu'il manque de 'vraies' cibles embarquées).

Un autre problème ici est que FreePascal lie généralement statiquement (car il n'est pas ABI stable et il est peu probable qu'il soit déjà sur le système cible même s'il l'était) son propre RTL. GCC établit des liens dynamiques avec les bibliothèques système. Cela fait que les très petits programmes (en termes de taille de source) créés avec fpc ont des binaires beaucoup plus grands que ceux créés avec GCC. Il convient de mentionner ici que la taille binaire n'a rien à voir avec l'empreinte mémoire du programme. FPC est généralement bien meilleur à cet égard que GCC.

Pourtant, je pense que compte tenu des ressources, FPC se porte extraordinairement bien.

Comparaisons avec Delphi

Dans les comparaisons avec Delphi, il faut garder à l'esprit que la conception de Delphi 32 bits provient de la période où beaucoup de gens n'avaient même pas de Pentium-I, et le développeur qui avait 32 Mo de RAM était chanceux. De plus, Delphi n'a pas été conçu pour être portable.

Compte tenu de cela, Delphi a assez bien évolué, bien qu'il y ait toujours place à l'amélioration et à des réajustements qui corrigent les problèmes historiques et les compromis. (C'est un fait assez bien connu que beaucoup de routines d'assembleur dans les plus récents Delphi étaient plus lentes que leurs équivalents Pascal, car elles n'ont jamais été mises à jour pour les processeurs plus récents. On dit que cela n'a été corrigé que depuis Delphi 2006.)

Pourtant, lentement sur le front du compilateur, FPC n'est plus le pauvre cousin de Delphi. Les comparaisons sont frontales, et le gain de FPC 2.1.1 sur Delphi devient lentement la règle, et non plus l'exception.

Bien sûr, ce n'est que le compilateur de base. Dans d'autres domaines, il y a encore assez de travail à faire, bien que l'éditeur de liens interne aide beaucoup. Le débogueur ne sera pas amusant cependant :-) Aussi dans l'interopérabilité des langages (C ++, Obj C, JNI) et les bibliothèques partagées, il y a beaucoup de travail à faire, même dans le système de base.

Comparaisons avec .NET/Java

Soyez très prudent dans les comparaisons avec ces systèmes compilés JIT: les programmes JIT-é ont des caractéristiques de référence différentes, et l'extrapolation des résultats des benchmarks aux programmes complets est également différente.

Alors qu'un JIT peut parfois faire un excellent travail (en particulier dans les petits programmes qui consistent principalement en une seule boucle serrée), mais ce bon résultat ne s'adapte souvent pas. Dans l'ensemble, mon expérience est que le code compilé statiquement est généralement plus rapide dans la plupart des codes qui ne sont pas principalement liés par une boucle serrée hautement optimisable, malgré les nombreuses affirmations sur le net.

Une source quantitative assez intéressante pour cela est cette entrée Shootout faq. Une autre intéressante est memory allocation in JVM/.NET.

Notez que depuis 2007, Java 6 a soudainement provoqué un saut significatif dans les évaluations de fusillade Java (Java shootout-ratings), et commence à toucher le fond des compilateurs natifs normaux. Cela montre qu'il faut être très prudent en faisant écho aux sentiments sur le Web (à la fois positifs et négatifs) et s'en tenir à sa propre mesure, avec les conditions aux limites ajustées au domaine d'application dans lequel vous vous trouvez.

Analyse de diverses options

Tests sur Lazarus 0.9.29 avec FPC 2.4 (FPC 2.2.4 sous Windows).

Compilateur optimisé signifie:

- 1. Projet|Options du projet...|Options du compilateur|Compilation et édition de liens|Lien intelligent (-CX) -> Coché

- 2. Projet|Options du projet...|Options du compilateur|Débogage| Décocher tout sauf 'Eliminer les symboles de l'exécutable Strip' (-Xs) -> Coché

- 3. Projet|Options du projet...|Options du compilateur|Compilation et édition de liens|Lier intelligemment (-XX) -> Coché

Le point le plus important semble être le 2. Pour une simple application la taille de lexécutable serait de 1-3 Mo au lieu de 15-20 Mo.

- 4. (facultatif) Projet|Options du projet...|Options du compilateur|Compilation et édition de liens|Plus petit plutôt que plus rapide (-Os) -> Coché (Avertissement: cela peut diminuer les performances en vitesse d'exécution).

Lazarus par défaut signifie comme installé depuis le setup.

LCL sans information de débogage signifie après reconstruction de lk'IDE Lazarus et de la LCL sans information de débogage (-g-).

| Lazarus par défaut | LCL sans information de débogage | |||

|---|---|---|---|---|

| Ubuntu 64 bits / Lazarus 64 bits | ||||

| Application par défaut | 13,4 Mb | 7,5 Mb / 8 | ||

| Compilateur optimisé | 4,4 Mb | 2,70 Mb (0.29svn FPC2.4 2,5) | ||

| Ubuntu 32 bits / Lazarus 32 bits | ||||

| Application par défaut | 19,6 Mb | 5,7 Mb | ||

| Compilateur optimisé | 2,9 Mb | 1,6 Mb | ||

| Windows XP 32 bits / Lazarus 32 bits | ||||

| Application par défaut | 11,8 Mb | 2,14 Mb | ||

| Compilateur optimisé | 1,62 Mb | 1,50 Mb | ||

| Windows Seven 64 bits / Lazarus 64 bits | ||||

| Application par défaut | 12,3 Mb | 3,20 Mb | ||

| Compilateur optimisé | 2,14 Mb | 2,16 Mb | ||